Gab es eine signifikante Verzerrung zwischen dem Ensemble von Klimamodellen und den langfristigen Temperaturtrends?

Was ist mit räumlichen Mustern?

Gab es eine signifikante Verzerrung zwischen dem Ensemble von Klimamodellen und den langfristigen Temperaturtrends?

Was ist mit räumlichen Mustern?

Sie können sich die technische Zusammenfassung des neuesten IPCC-Bewertungsberichts (5) ansehen.

Das thematische Fokuselement Nr. 3 lautet "Vergleichen von Projektionen aus früheren IPCC-Bewertungen" mit Beobachtungen "

Es heißt:

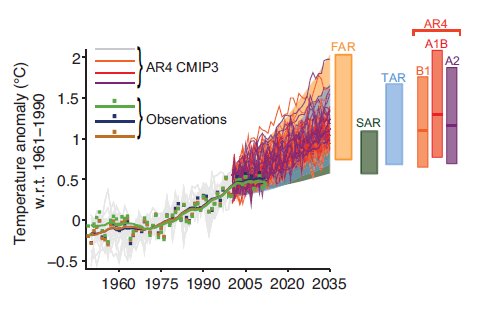

Globale mittlere Temperaturanomalie

Im Vergleich zum Mittelwert von 1961–1990 war die GMST-Anomalie positiv und größer als Seit 2001 0,25 ° C. Die Beobachtungen liegen im Allgemeinen gut im Bereich des Ausmaßes der früheren IPCC-Projektionen (TFE.3, Abbildung 1, Mitte links). Dies gilt auch für die Ergebnisse des Coupled ModelIntercomparison Project Phase 5 (CMIP5) (TFE.3, Abbildung 1; Mitte rechts) in dem Sinne, dass die beobachtete Aufzeichnung innerhalb des Bereichs der Modellprojektionen liegt, jedoch am unteren Ende der Wolke. MtPinatubo brach 1991 aus (siehe FAQ 11.2 für eine Diskussion darüber, wie Vulkane das Klimasystem beeinflussen), was zu einer kurzen Periode relativ globaler mittlerer Abkühlung in den frühen 1990er Jahren führte. Die ersten, zweiten und dritten IPCC-Bewertungsberichte (FAR, SAR und TAR) enthielten keine Auswirkungen auf Vulkanausbrüche und enthielten daher keine Berücksichtigung der mit dem Pinatubo-Ausbruch verbundenen Abkühlung. AR4 und AR5 schlossen jedoch die Auswirkungen von Vulkanen ein und simulierten erfolgreich die damit verbundene Abkühlung. In den Jahren 1995–2000 war die globale mittlere Temperaturanomalie recht unterschiedlich - ein erheblicher Teil dieser Variabilität war auf den großen El Niño in den Jahren 1997–1998 und den starken Rücken an Rücken La Niñas in den Jahren 1999–2001 zurückzuführen. Die mit diesen Bewertungsberichten verbundenen Projektionen versuchen nicht, die tatsächliche Entwicklung dieser Ereignisse in El Niño und La Niña zu erfassen, sondern schließen sie als Quelle der Unsicherheit aufgrund natürlicher Variabilität ein, die beispielsweise durch den Bereich der einzelnen CMIP3- und CMIP5-Simulationen umfasst wird und Projektion (TFE.3, Abbildung 1). Der graue Keil in TFE.3, Abbildung 1 (Mitte rechts) entspricht dem indikativen wahrscheinlichen Bereich für Jahrestemperaturen, der vom Vertreter bestimmt wird Der von Concentration Pathways (RCPs) ermittelte Wert für den 20-Jahres-Mittelwert 2016–2035 (Einzelheiten siehe Abbildung TS.14 und Abschnitt 11.3.6). Von 1998 bis 2012 lagen die Beobachtungsschätzungen weitgehend am unteren Ende des Bereichs, der allein durch die Szenarien in früheren Bewertungsberichten und CMIP3- und CMIP5-Projektionen vorgegeben wurde. {2,4; Box9.2}

Ich habe auch ein Bild aus dieser Zusammenfassung angehängt:

Geschätzte Änderungen in Die seit 1950 beobachteten globalen und jährlich gemittelten Oberflächentemperaturen bezogen auf 1961–1990 (in ° C) im Vergleich zu den Projektionen aus den vorherigen IPCC-Bewertungen. Die Werte werden harmonisiert, um mit dem gleichen Wert von 1990 zu beginnen. Beobachtete globale Jahrestemperaturanomalie im Vergleich zu 1961–1990 anhand von drei Datensätzen, die als Quadrate und geglättete Zeitreihen als durchgezogene Linien aus dem Gitteroberflächentemperaturdatensatz 4 des Hadley Center / Climatic Research Unit (HadCRUT4) angezeigt werden ; hellgrün), zusammengeführte Land-Ozean-Oberflächentemperaturanalyse (MLOST; warmer Senf) und Goddard Institute for Space Studies (GISTEMP; dunkelblau) -Datensätze. Die farbige Schattierung zeigt den projizierten Bereich der globalen jährlichen mittleren Änderung der oberflächennahen Temperatur von 1990 bis 2035 für Modelle, die in FAR (Abbildung 6.11), SAR (Abbildung 19 in der TS von IPCC 1996), TAR (vollständiger Bereich von TAR, Abbildung 9.13 (b) verwendet wurden. ). Die TAR-Ergebnisse basieren auf den in dieser Bewertung vorgestellten einfachen Klimamodellanalysen und nicht auf den einzelnen dreidimensionalen Klimamodellsimulationen. Für die AR4-Ergebnisse werden einzelne Modellläufe des CMIP3-Ensembles für den historischen Zeitraum von 1950 bis 2000 (hellgraue Linien) und für drei SRES-Szenarien (A2, A1B und B1) von 2001 bis 2035 dargestellt. Für die drei SRES-Szenarien zeigen die Balken das CMIP3 Ensemble-Mittelwert und der wahrscheinliche Bereich von –40% bis + 60% des Mittelwerts, wie in Kapitel 10 von AR4 bewertet.

Klimaprojektionen sollten nicht als deterministische Projektion des Klimas angesehen werden. Da das Erdsystem nicht linear (d. H. Chaotisch) ist, sind für die nächsten Jahrzehnte viele Wege möglich. Mit anderen Worten, die Statistik des Klimas (d. H. Trend, Variabilität zwischen den Jahren, räumliche Muster) der nächsten drei Jahrzehnte könnte näher an den Klimaprojektionen 2060-2090 liegen als an der Klimaprojektion 2020-2050.

Diese Art des Vergleichs liegt im dekadischen Vorhersagerahmen. Dies ist eine aufstrebende Wissenschaft für sich. Eine, die weit davon entfernt ist, für die Hauptsendezeit bereit zu sein. Die in den neunziger Jahren durchgeführten Simulationen zielten nicht auf eine solche zeitliche (dekadische) Vorhersage ab.

Ich beantworte die Frage nicht direkt, sondern weise lediglich darauf hin, dass solche Vergleiche irreführend sein könnten. P. >

Einige Vergleiche deuten darauf hin, dass historische Modelle die beobachteten Temperaturen schlecht simulieren.

Dieses Bild aus einem Naturartikel ist die klarste Analyse, die es gibt vermeidet die verschiedenen Verschleierungen, die beim Betrachten von verrauschten Zeitreihendaten möglich sind:

Die von diesen Autoren getroffene Wahl besteht darin, nur das durchschnittliche Ausmaß zu vergleichen der Erwärmung über einen Zeitraum anstatt der lauten Zeitreihen. Dies scheint einige der Entscheidungen zu vermeiden, die den Zeitreihenvergleich so verschleiert und kontrovers machen (tatsächlich stimmen ihre Ergebnisse nicht sehr mit denen überein, die in der vorherigen Antwort des IPCC gezeigt wurden, sie wählen lediglich eine Präsentationsmethode, die den Vergleich hervorhebt zwischen Modellen und Beobachtungen). Ihr Ergebnis scheint zu zeigen, dass die meisten Modelle die tatsächliche Erwärmung in den letzten Jahren tatsächlich überschätzen. In ihren Worten:

Die kürzlich beobachtete globale Erwärmung ist deutlich geringer als die von Klimamodellen simulierte.

Etwas ausführlicher sprechen die Autoren über Statistiken wie dies (meine Highlights):

Die Evidenz zeigt daher, dass die aktuelle Generation von Klimamodellen (wenn sie als Gruppe mit den von CMIP5 vorgeschriebenen Antrieben betrieben werden) die beobachtete globale Erwärmung in den letzten 20 Jahren oder die Verlangsamung der globalen nicht reproduziert Erwärmung in den letzten fünfzehn Jahren . Diese Interpretation wird durch statistische Tests der Nullhypothese gestützt, dass die beobachteten und die mittleren Modelltrends gleich sind, vorausgesetzt, dass entweder: (1) die Modelle untereinander austauschbar sind (dh die Ansicht „Wahrheit plus Fehler“); oder (2) die Modelle sind untereinander und mit den Beobachtungen austauschbar (siehe ergänzende Informationen). Unterschiede zwischen beobachteten und simulierten 20-Jahres-Trends weisen p-Werte (ergänzende Informationen) auf, die zwischen 1993 und 2012 unter Annahme (1) auf nahe Null und unter Annahme (2) auf 0,04 fallen (Abb. 2c). Hier stellen wir fest, dass je kleiner der p-Wert ist, desto stärker die Beweise gegen die Nullhypothese sind. Auf dieser Grundlage ist die Seltenheit der Trenddifferenz 1993–2012 unter Annahme (1) offensichtlich. Unter der Annahme (2) impliziert dies, dass eine solche Inkonsistenz nur einmal in 500 Jahren zufällig auftritt, wenn 20-Jahres-Zeiträume als statistisch unabhängig angesehen werden. Ähnliche Ergebnisse gelten für Trends für 1998–2012. Zusammenfassend lehnen wir die Nullhypothese ab, dass die beobachteten und die mittleren Modelltrends gleich sind.

Die Schlussfolgerung ist, dass die meisten Modelle (oder möglicherweise die meisten Ergebnisse aus dem Ensemble von Modellen) mehr vorhersagen Erwärmung, die tatsächlich passiert ist. Ob dies ein erhebliches Problem für Modelle darstellt, wird in den nächsten Jahren mit der Anhäufung von Beobachtungsdaten deutlicher. Die Autoren schließen einige Vorbehalte ein:

Andere Faktoren, die zur Diskrepanz beitragen, könnten eine fehlende Abnahme des stratosphärischen Wasserdampfs (dessen Prozesse sind) sein in aktuellen Klimamodellen nicht gut vertreten), Fehler beim Aerosolantrieb in den CMIP5-Modellen, eine Verzerrung des vorgeschriebenen Trends der Sonneneinstrahlung, die Möglichkeit, dass die vorübergehende Klimasensitivität der CMIP5-Modelle im Durchschnitt zu hoch sein könnte oder eine mögliche ungewöhnliche Episode von interne Klimavariabilität oben nicht berücksichtigt. Letztendlich werden die Ursachen dieser Inkonsistenz erst nach einem sorgfältigen Vergleich der simulierten internen Klimavariabilität und der Klimamodellkräfte mit Beobachtungen aus den letzten zwei Jahrzehnten und durch Warten auf die Reaktion der globalen Temperatur in den kommenden Jahrzehnten verstanden.

Andere Autoren haben die Frage mit einem etwas anderen und weniger direkten Ansatz behandelt. Sie neigen dazu, die implizite Klimasensitivität (grob gesagt: wie viel Erwärmung wir von einer kurz- oder langfristigen Verdoppelung der CO 2 -Niveaus erwarten) anhand von Beobachtungen und Modellen zu vergleichen. Mehrere neuere Veröffentlichungen haben niedrigere Schätzungen (insbesondere für die vorübergehende Klimareaktion) als die Werte in Klimamodellen gezeigt (siehe Lewis & Curry; Aldrin et al.; Otto et al.; Skeie et al..

Zusammenfassung Die Frage war, ob Modelle die tatsächliche Leistung gut simulieren zukünftiges Klima. Diese Ergebnisse deuten darauf hin, dass dies nicht der Fall ist. Es besteht jedoch eine große wissenschaftliche Unsicherheit darüber, ob dieses Versagen signifikant ist.